2025-09-30 09:01:43

近年来,大语言模型在处理长文本任务中展现出强大能力,但也面临着计算复杂度高、推理速度慢的挑战。DeepSeek-AI 最近发布了实验性模型 DeepSeek-V3.2-Exp,通过引入一种新颖的稀疏注意力机制(DeepSeek Sparse Attention, DSA),在保持模型性能的同时,显著提升了长上下文任务中的训练与推理效率。

DeepSeek Sparse Attention 主要由两个部分组成:

传统的注意力机制在计算时需要关注序列中所有之前的令牌,导致计算复杂度为 O(L2)O(L2),其中 LL 是序列长度。而 DSA 通过索引器为每个查询令牌筛选出最相关的 kk 个键值令牌,将复杂度降至 O(L⋅k)O(L⋅k),其中 k≪Lk≪L。

具体来说,索引器会为每个查询令牌计算一个“注意力分数”,并只保留分数最高的 kk 个令牌参与后续的注意力计算。这一机制不仅减少了计算量,还保留了模型对关键信息的捕捉能力。

DeepSeek-V3.2-Exp 是基于 DeepSeek-V3.1-Terminus 继续训练得到的。训练过程分为两个阶段:

整个训练过程使用了 128K 长度的上下文数据,总计训练了近千亿令牌。

在多项基准测试中,DeepSeek-V3.2-Exp 的表现与 V3.1-Terminus 基本持平,甚至在部分任务中有所提升。例如:

更重要的是,在长上下文推理场景中,V3.2-Exp 的推理成本显著降低。图3显示,随着序列长度增加,其推理速度优势愈发明显。

DSA 是基于 DeepSeek 自研的 MLA(Multi-head Latent Attention)架构实现的,特别采用了 MQA(Multi-Query Attention)模式,使得每个键值条目可以被多个查询头共享,进一步提升计算效率。

尽管内部测试结果令人鼓舞,DeepSeek-AI 仍在积极推进在真实场景中的大规模测试,以进一步验证稀疏注意力架构的鲁棒性与实用性。

DeepSeek-V3.2-Exp 的发布,不仅展示了一种高效的长上下文处理方案,也为大模型在保持性能的同时降低计算成本提供了新的思路。如果你对技术细节感兴趣,可以访问其开源实现:

希望这篇博客能帮助你理解 DeepSeek-V3.2-Exp 的核心价值与技术亮点。如果你有更多问题,欢迎继续提问!附该技术报告英中对照版,仅供学习参考:

2025-09-01 15:23:24

近日,美团 LongCat 团队发布了 LongCat-Flash 模型及技术报告,这是一款总参数量达 5600亿 的混合专家模型(Mixture-of-Experts, MoE),在保持高性能的同时,显著提升了训练与推理效率,尤其擅长处理需要多步推理和工具调用的智能体(Agent)任务。

传统MoE模型中,每个token都会激活固定数量的专家,但LongCat-Flash引入了“零计算专家”机制,允许模型根据上下文重要性动态分配计算资源。简单来说,重要的token会激活更多专家,不重要的则激活较少甚至零计算专家,直接返回输入值,不进行额外计算。

MoE模型在扩展时常遇到通信瓶颈。LongCat-Flash采用ScMoE结构,通过跨层快捷连接,将密集FFN计算与MoE层的通信操作重叠执行,大幅提升训练和推理效率。

LongCat-Flash在多项基准测试中表现优异:

LongCat-Flash已全面开源,包括模型权重、推理代码和部分训练数据,推动MoE架构、高效训练与智能体研究的进一步发展。

LongCat-Flash不仅在模型架构上实现创新,更在训练策略、系统优化和智能体能力培养方面树立了新的标杆。其高效的推理性能和优秀的任务表现,使其成为业界领先的开源MoE模型之一,有望推动AI智能体在真实场景中的广泛应用。

附美团LongCat-Flash模型技术报告英中对照版,仅供学习参考:

2025-08-11 17:14:58

在追求通用人工智能(AGI)的道路上,智能体能力(Agentic)、复杂推理(Reasoning) 和编程能力(Coding) 是衡量大模型综合实力的“黄金三角”。而最新开源的 GLM-4.5 系列,正是以“ARC三位一体”为目标打造的超级模型,以3550亿参数登顶全球开源模型性能前三!

1. 高能效设计

2. 混合推理引擎

markdown

| 推理模式 | 适用场景 | 技术特点 | |--------------|---------------------------|------------------------| | 思考模式 | 数学/科学/多步工具调用 | 长链式思维(CoT) | | 直答模式 | 聊天/翻译/简单问答 | 低延迟响应 |

模型可动态切换模式——复杂问题启动深度思考,简单任务秒级回应,兼顾效率与精度。

1. 智能体能力(Agentic)

2. 推理能力(Reasoning)

3. 编程能力(Coding)

综合ARC 12项基准:全球排名第3(开源第1),智能体单项排名第2!

1. 预训练数据革命

2. 中训练(Mid-Training)

3. 后训练专家蒸馏

python

# 专家迭代流程 1. 分领域训练专家模型:推理专家 + 智能体专家 + 通用聊天专家 2. 自我蒸馏融合:将专家能力注入统一模型 3. 混合强化学习: - 推理RL:难度分级课程(先易后难) - 智能体RL:轨迹自蒸馏迭代 - 病理RL:根治语言混合/格式错误

1. 逻辑推理

2. 颠覆级翻译能力

3. 终端编程实测

开发者提示:轻量版GLM-4.5-Air在106B参数下实现接近GPT-4的性能,推理成本降低60%!

GLM-4.5不仅证明了中国团队在MoE架构和强化学习领域的顶尖实力,更首次实现智能体-推理-编程三大能力的统一。其开源将加速AI智能体的实际落地——从自动代码修复到网页信息挖掘,一个真正“会思考、能执行”的AI时代正在到来。

项目地址:https://github.com/zai-org/GLM-4.5

在线体验:https://z.ai (支持128K上下文对话)

延伸阅读:报告中隐藏的4大技术彩蛋

本文数据均来自GLM-4.5技术报告,更多技术细节参见原始论文,附英中技术报告对照版,仅供学习参考:

2025-08-06 11:26:54

OpenAI 发布的 gpt-oss-120b 与 gpt-oss-20b 是首批面向开源社区、同时强调“强推理+工具调用”的权重开放模型。以下从性能、安全与生态三个维度给出简评。

gpt-oss-120b/20b 的最大价值不仅是“性能对标闭源”,更在于示范了“开放权重+开放评估+可控风险”的新范式:让社区既能拿到可商用、可微调的强模型,又能复现其风险测量与缓解路径。对于追求本地私有化、成本敏感或需深度定制的开发者,这套组合极具吸引力;对于行业而言,它把“安全可验证的开源大模型”向前推进了一大步。

以下是该技术报告英中对照版,仅供学习参考:

2025-07-22 14:13:07

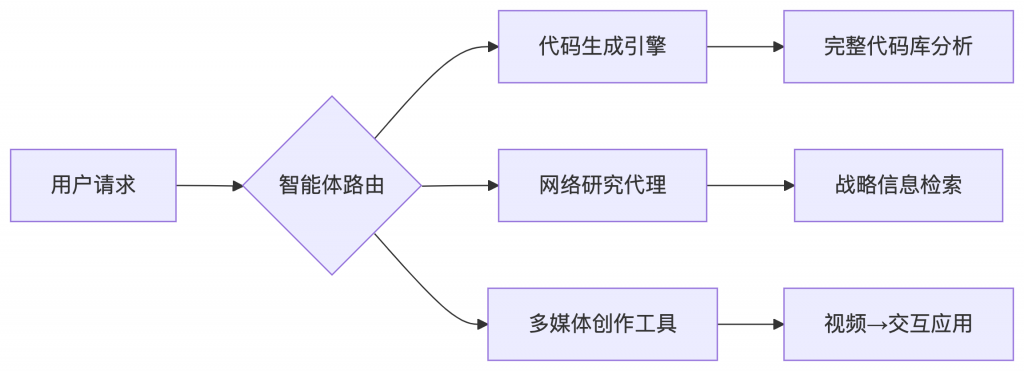

过去两年,大模型的竞争主线从「参数规模」转向「推理深度」再到今天的「智能体能力(Agentic Intelligence)」。

Kimi K2 用一份 32 页的技术报告告诉我们:开源模型第一次在「非思考」条件下,同时在代码、数学、工具调用三大硬核基准上逼近甚至超越 Claude-4 系列。

更重要的是,K2 用一套完全开源的权重 + 数据管线 + RL 框架,把「智能体」这件事做到了可复现、可扩展、可落地。

| 维度 | K2 | DeepSeek-V3 | Llama4-Maverick |

|---|---|---|---|

| 总参数 | 1.04 T (MoE) | 671 B (MoE) | 400 B (MoE) |

| 激活参数 | 32 B | 37 B | 17 B |

| 专家数 | 384 | 256 | - |

| 注意力头 | 64 (节省 83% FLOPs) | 128 | 128 |

| 上下文 | 128 k | 128 k | 128 k |

一句话总结:在同样 32 B 激活量的前提下,K2 把专家数提升到 384,用更稀疏但更大的「外脑」换来单位 FLOP 的更高收益。

结论:在高质量数据见顶的时代,「可控改写」成为新的数据杠杆。

K2 构建了一个三层合成管线:

最终产出 数十万条 高质量工具调用轨迹,用于 SFT。

| 基准 | K2 | 开源 SOTA | 闭源标杆 |

|---|---|---|---|

| SWE-bench Verified (multi-attempt) | 71.6 % | 54.6 % (DeepSeek) | 80.2 % (Claude-4-Sonnet) |

| SWE-bench Multilingual | 47.3 % | 25.8 % | 51.0 % |

| LiveCodeBench v6 | 53.7 % | 46.9 % | 48.5 % |

解读:在「不思考」设定下,K2 把开源天花板抬高了 10~20 个百分点,与 Claude-4 的差距缩小到 5 个百分点以内。

作者坦诚当前局限:

未来路线图:

Kimi K2 用 15.5 T tokens、32 B 激活、1 T 总参数,把「开源模型做不到的事」清单划掉了一大半。

更重要的是,它把「如何训练一个可落地的智能体」拆解成了可复现的配方:

高效优化器 + 合成数据工厂 + 可验证 RL = Agentic Intelligence at scale

接下来,轮到社区去玩出更多花样了。

附技术报告英中对照版,仅供学习参考:

2025-07-15 11:15:42

近日,Google DeepMind发布了震撼业界的Gemini 2.5系列模型技术报告,标志着大模型技术迈入全新阶段。作为谷歌迄今最强大的AI模型,Gemini 2.5 Pro不仅在传统基准测试中大幅刷新记录,更在长上下文理解、复杂推理和多模态智能体能力上实现质的飞跃。本文将深度解析这一技术里程碑的核心突破与潜在影响。

Gemini 2.5系列基于稀疏混合专家模型(MoE) 架构,但进行了关键升级:

最革命性的创新是 “Thinking”机制:

# Thinking机制伪代码示例

def generate_response(query):

thought_tokens = allocate_thinking_budget(query) # 动态分配计算资源

for _ in range(thought_tokens):

internal_state = refine_thought(internal_state, query) # 迭代推理

return finalize_response(internal_state)

该机制允许模型在响应前进行数万次前向传播,显著提升复杂问题解决能力。在AIME 2025数学竞赛基准上,思考预算增加使准确率从72%跃升至88%。

Gemini 2.5 Pro实现了前所未有的多模态处理能力:

在VideoMME视频理解基准上,Gemini 2.5 Pro以84.3% 准确率超越GPT 4.1的72%,尤其在时空推理任务(如寻找跨镜头关联事件)上优势显著。

报告展示了Gemini作为智能体平台的核心能力:

尽管能力飞跃,报告揭示了关键挑战:

在关键能力评估中,Gemini 2.5 Pro尚未达到网络安全关键能力阈值(仅完成50%专业级攻防挑战),但已触发谷歌的加速监控机制。

Gemini 2.X系列覆盖完整帕累托前沿:

| 模型类型 | 核心优势 | 适用场景 |

|---|---|---|

| Gemini 2.5 Pro | 极限推理/多模态 | 科研、复杂代理系统 |

| Gemini 2.5 Flash | 动态计算平衡 | 企业级应用 |

| 2.0 Flash-Lite | 0.1秒响应延迟 | 移动端大规模部署 |

通过AI Studio平台,开发者可直接调用:

Gemini 2.5的突破印证了三个趋势:

正如DeepMind CEO Hassabis所述:"我们正在构建的不仅是工具,而是能理解并主动解决人类复杂需求的通用助手。" 当模型能在46分钟视频中精确定位1秒事件(见附录8.5),或在无视觉输入时仅靠RAM数据通关Pokémon,AI的能力边界已超越人类传统认知框架。

技术启示录:Gemini 2.5的进化速度暴露了AI领域的核心矛盾——当模型能力呈指数增长时,人类设计评估体系的能力却停滞在线性阶段。下一次范式突破,或许将始于AI自主设计评估标准的那一刻。

探索Gemini 2.5技术细节,附gemini 2.5技术报告英中对照版,仅供学习参考: