2026-02-01 13:22:59

打算把我相对能看得懂的公司商业模式捋一遍,今次讲讲迪士尼。老规矩,内容都是来着我自己这个老股东的理解,从开始建仓到现在,核心仓位拿了很多年了,也是我较大仓位长持的公司中整体回报率最低的一家。我一直奉行只买自己熟悉和(相对能)看得懂的公司这样一个基本原则,因此职业的关系手里大部分持仓都是科技股,像迪士尼这样的公司显得比较另类。

打算把我相对能看得懂的公司商业模式捋一遍,今次讲讲迪士尼。老规矩,内容都是来着我自己这个老股东的理解,从开始建仓到现在,核心仓位拿了很多年了,也是我较大仓位长持的公司中整体回报率最低的一家。我一直奉行只买自己熟悉和(相对能)看得懂的公司这样一个基本原则,因此职业的关系手里大部分持仓都是科技股,像迪士尼这样的公司显得比较另类。

迪士尼是一家传统媒体公司,核心就是内容创作和内容分发,不过和它的竞争对手比起来,它也是向科技激进转型(并且挣扎的)的 “新媒体”。如果说传统媒体有 Comcast 或者 Paramount,纯粹的新媒体像是 Netflix,那么迪士尼就好像是夹在中间。

就像之前分析阿里巴巴这艘商业巨轮一样,要去理解迪士尼的商业模式,可以从这样三个部分来分别审视:

迪士尼大概是地球上护城河最宽的非必须消费类公司之一,它的乐园、游轮,还有流媒体,都是护城河,但是一切护城河的核心在于 IP。所有的乐园、游轮、电影、商品,全都是围绕 IP 来运作的,没有 IP,就没有百年迪士尼。

比方说,现在有环球影城这样的主题乐园,发展很快,但是它们始终没法威胁到迪士尼的乐园。原因很简单,因为其它的主题乐园它们再豪华,也不是迪士尼认证的,没有迪士尼那些孩子们心中卡通人物的乐园。你也可以建造最刺激的过山车,但是它肯定不是星球大战过山车,也肯定不是冰雪奇缘过山车。你还可以生产便宜的玩具,但它肯定不是正版的米奇和他的朋友们,也不会是钢铁侠、绿巨人,或者朱迪或者尼克。所以,一句话,IP 就是护城河,IP 就是溢价。

从这个角度来说,IP 的推广,占据用户心智,才是迪士尼的根基。这也是我后来慢慢理解为什么迪士尼要自己做流媒体,砸钱做,即便一年一年亏钱还要继续砸。这里并不是一个简单的自己做流媒体远期能够提高利润率等方面的问题,这是一个生死存亡的问题。如果继续使用 Netflix 的平台,那么哪一天 Netflix 决定掐住迪士尼的喉咙,不让电视上继续播放迪士尼的的卡通形象,这些 IP 不能深入新一代孩子们的内心,无论这个过程有多缓慢,那最终迪士尼的这个经典的盈利的飞轮就彻底转不起来了。

前面说的体验部分和娱乐部分,基本都是围绕着迪士尼那些著名 IP 展开的,这是迪士尼最根基的商业模式。在此之上,也能看到一些其它次要一点的护城河,比如乐园、游轮也好,度假区也罢,都具备一个完整的消费环境,衣食住行,全部都在这个密闭的环境里面完成,结果就是,请把美好回忆带走,但务必把钱留下,这也是它第二重要的商业模式。通常来说,我是不太喜欢重资产的商业模式的,不过它的商业模式和护城河太经典和强悍了,我觉得可以为迪士尼开一个例外。

不过迪士尼的体育板块,还是和上面的略有区别,它的护城河主要是长期锁定的直播权。这部分逻辑上比较简单,并且是租来的,成本肯定没有完全自有的护城河那么可控,也没有那么强悍。

先说娱乐版图,它包含传统电视、流媒体和占比较小的内容销售。传统电视已经基本上是夕阳产业,现在在娱乐部分依然是贡献大头的利润,但是这部分没有成长性,逐渐萎缩。流媒体是 “转型的主力” 和 “全村的希望”,其实也可以说是刚刚转盈利,但是毕竟开始赚钱了,希望它是一个真正的困境反转。

流媒体伴随着盈利逐渐改善,有一个变化,就是不再纠结于用户数量的提升,而是通过涨价提升 ARPU 和增加广告收入。市场是很乐于看到涨价的,涨价也说明了用户粘性和护城河。

接着是体验版图,这有点像是阿里巴巴的传统电商部分,营收最高并且利润率低于娱乐部分,但能够不断提供源源不断的现金流来发展新业务(特别是前几年持续支持流媒体烧钱)。

美国的本土乐园其实保持低速增长就不错,但是国际乐园还是有很大的空间。只要没有疫情这样的黑天鹅,游轮业务也能逐渐缓慢扩张。总之,这部分通常比较稳定,这部分也是较重的资产和员工人数的主要来源。

最后是体育版图,ESPN 是盈利的,但是面临体育版权费越来越贵的压力。从内容上看,Hulu 和 ESPN 最初似乎都和 Disney 的背景格格不入,但是这是迪士尼扩展用户群的一着棋。ESPN 曾经是非常赚钱的,包括联盟费和广告费等等,但是现在因为有线电视的衰退,这部分有点往鸡肋方向靠拢。然而,无论利润率如何,ESPN 有它的战略地位,ESPN 是 Disney 和 Netflix 竞争的重要筹码。

和很多巨头不一样的是,从 2015 年到现在(2026 年),差不多十年了,迪士尼的股价一直在一个范围内波动,没能获得突破。这挺让人感慨,然而看似卡住的股价背后,发生了天翻地覆的变化。这个转身对于如此传统的一家媒体巨头来说,实属不易。这让我想起了微软 Office 上云的商业模式迁移。

首先,710 亿天价收购 Fox,主要目的是扩充 IP 库。Fox 收购是伤筋动骨的(别忘了当时的净利润只有 120 多亿),为此背负了巨额债务。但是老 Bob(Bob Iger)还真的是既有眼光,又有魄力,如果没有这笔收购,没有内容怎么做流媒体,只有那米老鼠和漫威等等几十部电影。而且除了内容,还拿到了 Hulu 的控制权,这不但从儿童动画拓展到成人剧集,而且技术和运营上它的经验对于做 Disney+是很有帮助的。这笔收购的战略意义太过重大,要是没有 Fox 收购,就没有今天的阿凡达,就没有 X 战警,也没有辛普森和冰河世纪;要是没有 Fox 收购,迪士尼就没法做流媒体,IP 和品牌就会慢慢衰落,前面已经说到了。看看 Paramount,它也是传统媒体,也有海绵宝宝和 Paw Patrol 之类的一堆 IP,但是现在呢,被 Oracle CEO 拉里埃里森的儿子收购和合并。所以,从今天的角度看,这把操作代价是巨大的,但是整体看来还是正确而重要的一步。

然后就是做 Disney+烧钱,跟 Netflix 正面刚。就像一个退休了的老头重新出山来和年轻人在科技领域竞争,学习怎么玩互联网,很不容易,直到现在也谈不上 “擅长”——现在 Netflix 的利润率接近三成,而 Disney+只有个位数。但是因为传统的电视领域的衰落,这是它没有退路的一步棋。从这个角度看,百年老店迪士尼还是非常值得尊敬的,我相信大多数企业都抗不过这个时代的变革。

之后再加上疫情的打击(这类非必须消费而且是重资产,疫情打击是非常大的),分红被迫暂停,股本也一路膨胀,一直到 2023 年结束。之后因为财务状况改善,才慢慢通过回购好起来,现在大致还算处于一个变革期,但是从回购恢复和分红增长来看,最艰难的时间可能已经过去了。

如今,市场关心 Bob Iger 二次出山之后,他需要再次隐退,那谁来接班呢?这可能是短期内迪士尼最大的风险,想起之前 CEO Bob Chapek 被认为把财务放在艺术和传统之上,得了大罪,于是 Bob Iger 被迫重新出山。其次,是袭来的 AI 革命,对于传统动画制作门槛的降低,那么多不确定性都等待尘埃落定。再一个,就和很多重资产的经营一样,这一类生意的脆弱性——疫情也好,衰退也好,一旦出现,它就会受到直接的打击。

再来说说和 Netflix 的竞争,市场迫切希望看到 Disney+能将迪士尼的增长带出来。在我看来,如果要去和 Netflix 拼内容宽度,是没有胜算的。Netflix 在流媒体这块的统治力太足了,无论是内容库的丰富程度还是技术的成熟度,都是迪士尼无法望其项背的。

那么,迪士尼还是要靠自己的 IP,也许用户量没法和 Netflix 比,但是用户心智对于 IP 的深度要培养起来。如果流媒体搞成功了,迪士尼的未来可以打八十分往上,但是如果没搞成功呢?也未必是世界末日,如果我们换个角度思考,和流媒体起着生死攸关作用的 Netflix 不同,对于迪士尼来说,或许流媒体未必非得要有多少盈利,它完全可以只扮演一个 “药引子”——流媒体本身只是渠道,用户看了 Netflix 的动画,整个消费场景就结束了;而用户看了迪士尼的动画,消费场景才刚刚开始,之后他会去乐园、去游轮,去买周边等等。

最后,在这个竞争上,迪士尼还有一个优势,就是 Disney+的动画、Hulu 的神剧和 ESPN 的体育直播捆绑起来的优势,这里面有很多 Netflix 完全没法竞争的内容。

我们在比护城河的时候,主要是在比商业模式。Netflix 呢,它虽然成长很快,但它只有单纯的流媒体和相应的内容,全球用户已经到 3.25 亿了,往上的空间不大,增长很快会遇到天花板(从它最近要收购华纳兄弟来看,也许管理层觉得这一天已经到来了)。因此把时间放长来看,除非它有了新的业务拓展曲线,否则我认为 Netflix 的护城河和 Disney 是完全没法比的。

总之,迪士尼是一家成熟,但在努力转型以根上时代的公司,成长性看起来没有很多互联网公司那么强,但是我还是相信它在这些经典 IP 上的积累,相信它的商业模式,也相信它能平安度过科技转型和困境反转的阶段,价值得到回归。百年迪士尼为我们童年带来过美好的回忆,我真心希望它可以再继续创造经典的角色,陪更多的孩子们度过童年。

文章未经特殊标明皆为本人原创,未经许可不得用于任何商业用途,转载请保持完整性并注明来源链接 《四火的唠叨》

2026-01-26 13:18:29

之前聊到过拼多多,今天聊一下阿里巴巴。阿里巴巴作为中概元老,很多人都讨论过,我只发表从我的角度浅显的看法。作为利益相关者,我持有阿里巴巴个股,且在中国科技相关的 ETF 和基金中的被动持有仓位。

之前聊到过拼多多,今天聊一下阿里巴巴。阿里巴巴作为中概元老,很多人都讨论过,我只发表从我的角度浅显的看法。作为利益相关者,我持有阿里巴巴个股,且在中国科技相关的 ETF 和基金中的被动持有仓位。

首先,要理解阿里巴巴,需要从它的五块构成来分别理解:

这是我对阿里最初的印象。中国是互联网电商发展最快的国家之一,阿里巴巴作为时代的开拓者,当然也吃到了其中的红利。不过,现在看起来要守住市场份额也开始烧钱了,一旦一家公司要在某个成熟的业务上大手笔地烧钱,我认为这可能就是一个极其危险的信号。凡是进行价格战的生意,基本都很难说是好生意,真正有护城河的生意,是不屑于降价的。

这个烧钱,说到底,主要是为了和拼多多抗衡,打出了百亿补贴的牌。但是阿里的降价不仅关乎到陡降的利润率,也打击了天猫上商户的品牌形象。到了去年,尤其是下半年,又开始大干特干即时零售。这种烧掉利润来稳住市场份额的行为,有点像是医疗上的激素冲击,是最 “简单粗暴” 的方式,却也终究是不可持续的。

其实我又想起了京东几年前的一波降价,之后股价就被打到地板上了,如今基本上作为一家重资产的 PE 在个位数的电商,可以作为烟蒂股了。说到底,那件事和如今阿里巴巴做的事情也没有什么本质区别,零售业就是一门苦生意。

张勇作为 CEO,战略上畏手畏脚,思维圈子也似乎跳不出一个 CFO 的局限,虽说没像百度一样把一副好牌完全打烂,却也做错了很多事情。比如一开始对下沉市场彻底放弃,后来再搞淘特,发现根本打不过拼多多;比如低效率的中台战略,让阿里巴巴变成了一家看起来有着严重大公司病的企业。

吴泳铭上任以后,情况有了转机。阿里一直以来都为流量入口的事情烦恼,这两年它做对的一件事情就是接入微信支付。第二件就是它搞清楚了对它最大价值的人是谁(这是它和拼多多商业模式不一样的地方,我在分析拼多多的文章里面谈到过),是商家还是消费者,它选择没有跟风拼多多的 “仅退款” 跟到底,而是给高信用的商家一定的申诉通道。还有就是卖掉那些实体零售,利润率低,或者就是亏钱的重资产,像什么大润发和苏宁易购等等。这些都是这两年做对了的事情,虽说这些目前还没有从根本上改变电商基本盘的所处格局。

阿里云和 AI 基本就是阿里增长的最大希望,市场认可的估值弹性得有好大一部分是来自于它(差不多一半?)。这也是 2025 年阿里市值回弹比很多对手快得多的原因之一。如果没有这部分,阿里就基本是查理芒格说的 “该死的零售商” 而已了。

云计算在近年来增速加快的同时,盈利也终于在电商疲软的时候撑起了一片天。其实中国的云计算整体起步并不算晚,由于企业数字化和需求各异性太强等问题,盈利一直是一个问题。现在市场希望的是,阿里能像当年的 AWS 一样,把阿里云做成增长和利润的大头来源。

想起来移动互联网最火的时期,阿里云的增速是能够超过 50% 的,后来掉下来了,一方面是 TikTok 跑了,另一方面是在线教育等多个行业遭受寒冬,需求减少了。不过 2025 年以来,借助 AI 的东风,云计算增速重启(这部分差异全是 AI 带来的,传统云服务增速依然只有个位数)。但是这个趋势能够维持多久,就决定了从目前的角度看,阿里的估值能维持多久。这个答案对我而言是不确定的。相对来说,腾讯的估值倍数和阿里差不多,但是它的利润和增长,或者说到护城河,都要稳健得多。

阿里当年是差点要拆分阿里云出去单独上市的,如果真那么做了。如今的阿里云就要弱小得多,发展基本肯定不如现在,而阿里集团就会因为电商的侵蚀被打到地板上,那就可以说是双输的结果。还好,这一步险棋没有走出去。

说到 AI 模型,就要提到阿里的通义千问,它的 API 几乎要成为中国国内的标准了,我也看到它把阿里旗下的各个业务串起来的潜力。阿里卖模型 API 的时候,也就把模型本身和 AI 算力都一起卖出去了。阿里还有一件事做得很对,就是把模型开源,这样开发者使用了模型,会更愿意部署在阿里云上。

中国 AI 云市场接下去好几年年均增长都可以超过四成,阿里云既包括云基础设施,又包括模型服务,两个细分领域都是龙头,属于高增长板块中的龙头,也就难怪市场愿意给相对的高估值了。

要说这部分的风险,主要有两个方面。

一个是老生常谈的芯片卡脖子问题,但是这部分市场盯得紧,而且后果未必有想象得那么严重,可能高端芯片缺乏,较低端的芯片会降低计算效率。对于自研芯片,阿里的平头哥可能会独立融资,但是芯片不像电动车,商业地位上要产生实质性竞争力,需要走的路还远得很。

另一个是,现在属于烧钱抢市场阶段可以理解,但等 AI 大模型慢慢成熟以后,利润率到底还能不能保持高位是一个问题,或者说,到时 AI 大模型会不会又会变成零售一样,卷到天上去。现在的大模型属于百花齐放期,但是我认为这里的护城河没有很多人想象得宽,就像大多数领域一样,最后只能剩下几家大的玩家,并且很可能大部分钱都会被最大的一家赚走。总之,届时对于大多数用户来说,不同大模型的质量差异也可能并不大,那种情况下鉴于可替代性,利润率就不可能挺得住。

2025 年经历了一波大甩卖,无底洞都摆脱了,剩下的都还是比较不错的业务。阿里出海基本上 breakeven 了,结合菜鸟物流,阿里速卖通就能够用配送时间去和 Temu 竞争。电商出海的营收规模接近阿里云,从营收看,淘宝、天猫是阿里的身体,那阿里云和电商出海就是走路的两条腿。

对于其他业务,除去菜鸟,大部分还是亏损的。2025 年大卖特卖的也都是这部分的业务。

再说投资,阿里之前的投资水准实在不能算好。不过,阿里在吴泳铭上任后卖掉了很多移动互联网时期开始投资的股权,一种是战略关联性低的业务,比如小鹏汽车、B 站和快狗打车等等;另一种是重资产业务,比如大润发和苏宁易购等等。并且,很多卖出都是止损而非止盈,这些为了打云计算和 AI 的战役筹备了弹药。看起来撑面子的营收规模下降了,但这让阿里聚焦核心业务,变得更加轻资产,最实质的利润率却是提升的。

现在阿里主要的投资,首先是蚂蚁集团,不知道什么时候还能再上市,但是目前盈利能力不容置疑,大概是这里面最值钱的资产。其它投资还包括中国国内 AI 的独角兽们,几大物流公司,还有媒体领域的微博,基本上都是具备战略地位的。阿里对投资人的回报也在改进。阿里开始提供一定的分红,并且大量回购,把自己定位为一个开始偏向成熟的企业。

总体来看,阿里的投资,从张勇时代的重资产,开始逐渐转向吴泳铭时代的轻资产和科技。从过往张勇时期的记录来看,看看腾讯的投资能力,比一比就能发现,阿里差远了。有句话叫做 “腾讯投资是把半条命交给合作伙伴,而阿里巴巴则是想要对方的整条命”。腾讯投资给对方资金和流量(京东、美团、拼多多,还有无数游戏公司),而阿里则是把对方买回来阿里化(饿了么、优酷、土豆等),全部融入进来管,结果还往往管不好。

基本上,中国的企业当中,大概阿里巴巴就是能看懂一些的少数几家之一。它最初的牌兴许比腾讯还好,但是后来打烂了,但是又没有像百度那样彻底烂掉。吴泳铭时代还是给了市场很多正面的回馈,当然,现在这个价格,我认为性价比是要低于腾讯的。

我认为阿里的电商护城河还将继续持续被侵蚀,而 AI 对于阿里就相当于 “全村的希望”,这基本是阿里最大的希望,如果 AI 能够做成,它会是一笔很好的投资,但是风险上看,显然是高于腾讯的。我目前还继续持有阿里巴巴的仓位,但是 conviction 没有那么强烈,因此仓位也不很大。如今考虑进去地缘政治因素,阿里巴巴已经不再严重低估,但也不能算有多贵,但是我更关心的是我操作上的逻辑,只要哪天我确认阿里云的增速下来了,或者 AI 并没有预期的那么强大,我清仓个股的逻辑就会确立。在当前的价格,如果未来我找到优质得多的标的,我也许也会换出去。当然,我依然相信中国的科技,依然会持有中国科技的基金和 ETF,这部分中阿里巴巴的被动持有会依然存在。

阿里巴巴记录了中国科技一个又一个时代,从电子商务到云再到 AI,衷心希望阿里巴巴能够巨人苏醒,王者归来。

文章未经特殊标明皆为本人原创,未经许可不得用于任何商业用途,转载请保持完整性并注明来源链接 《四火的唠叨》

2026-01-18 07:24:55

所谓投资,就是好公司+好价格,仅此而已。作为普通人,和基金和机构比起来,优势之一便是拥有自己独特的认知,这些认知,无论是多么小众,还是听起来多么 “常识”,如果用得好的话就是优势,是能够帮助投资变现的。

就我自己而言,符合这一条件的,我可能也能找出个别几家公司来,而 Atlassian 便是其中之一。我相信大多数人,特别是那些所谓的金融分析师对它未必了解,而作为软件工程师的我,则一直以来都使用它的产品,有的时间段内甚至是重度用户,自然对它我有我自己的认识。这支股票一直在我的列表上,截止本周五,Atlassian 的股价(TEAM)跌到一个非常诱人的程度(120 刀以下),我认为是一个非常好的机会。本来我一直就想写一些我对不同公司商业模式的看法,那正好这是一个很好的机会,就来聊一聊 Atlassian。这些都是我自己的观点,未必正确。

就我自己而言,符合这一条件的,我可能也能找出个别几家公司来,而 Atlassian 便是其中之一。我相信大多数人,特别是那些所谓的金融分析师对它未必了解,而作为软件工程师的我,则一直以来都使用它的产品,有的时间段内甚至是重度用户,自然对它我有我自己的认识。这支股票一直在我的列表上,截止本周五,Atlassian 的股价(TEAM)跌到一个非常诱人的程度(120 刀以下),我认为是一个非常好的机会。本来我一直就想写一些我对不同公司商业模式的看法,那正好这是一个很好的机会,就来聊一聊 Atlassian。这些都是我自己的观点,未必正确。

将近十年前离开 Amazon 以后,我经历的每家公司都使用 Atlassian 的产品,尤其是 Jira 和 Confluence,有时还有 BigBucket。尤其是在 Oracle 工作期间,我是真正的重度用户,每天接触大量的 Jira tickets,备受 Jira 系统的折磨,参与 Jira 稳定性的问题讨论,甚至还开发系统大量调用 Jira 的 API,我们自己实现的工作流引擎就支持复杂的 Jira 交互。当时有个戏谑的说法就是,Oracle Cloud 从上往下一层一层,什么 SaaS、PaaS、IaaS,其实下面还有最底下的一层,而这一层就是 Jira。

一直以来,Atlassian 在推动客户从本地私有部署进化成为云托管的(也有一些数据安全要求高的可能是其它数据中心的)。我觉得这个思路是非常正确的。本来,本地且不说支持服务的难度更高,营收的天花板才是最大的问题,客户上云之后,连带服务、新产品(包括 AI 的新特性)推送等等都可以很容易地进行,这比单纯的卖软件授权要有多得多的盈利可能性。

本地部署的情况下,费用收取可以采用按人头的方式,但是这种方法比较落后,上限很低,而且在 AI 时代要减少用工的短期趋势下,这是非常不利的。因此上云可以带来质量更高的订阅制收费模式,以及基于 feature、插件,甚至 AI token(配额)等等的收费模式。单客户的价值可以进一步提升。

从公开的数据来看,上云后,大客户流失率小于 2%,基本上这可以抹平一些人对于上云会丢失客户的担心了。这其实也体现出了产品的护城河。就拿 Jira 为例,很多人可能会觉得 Jira 是一个非常好用的跟踪问题的工具,不过我看到一种说法很有道理,完全相反,Jira 其实是一个很难用的工具,但是它的难用恰恰把你给绑住了。它可能用起来不是那么友好,但是它提供的复杂功能,加上历史数据,让你很难离开它。除去数据,Jira 本身也支持复杂的自定义工作流,整个流程(以及涉及到的部门和人)都被捆住了之后——想想看,功能、数据、流程和人,面对这样的强耦合,要想迁移开去,是非常难的,我想不是它真正的用户,是很难体会到这一点的。换言之,一旦上了贼船,要想下船岂是那么容易的?在上云之后,我相信 Atlassian 的定价权会进一步加强。

除去最核心的护城河——迁移成本以外,还有其它一些特性也构成了护城河,比如它的插件生态。生态的建立和谁先进入市场来培育用户有关,就像是 Amazon 的 Echo 从技术上也许不如 Google Home,但是它的生态建立起来了,各种应用和设备都和 Echo 整合起来了,其他厂商很难再进入了。Jira 有超过 5000 个插件,这让其他公司很难快速地做出一个替代品来。

最近一段时间,软件股、SaaS 股都被市场抛售,而且是不分青红皂白地抛售。对于 Atlassian,市场大致的逻辑是,AI 可以让写代码变得非常高效,那么软件流程管理工具 Jira 和 Confluence 这样的知识库工具就可能变得没有那么大的价值。可是,真的是这样吗?

其实,市场的担心不无道理。首先,按照人头收费的方式,在软件开发不需要那么多人的时候,就面临着自然而然的市场规模的收缩;其次,Jira 这种传统的数据存储的方式是结构化的,好处是 schema 清晰,便于处理,但是却不是最自然的人类记录数据的方式,而 LLM 才是能够 “理解” 和 “记忆” 非结构化数据的;最后,正是因为机器、流程、规则等等都喜欢结构化的数据,也正是因为它们的程序具备单一目的时才容易写出来,于是我们才创建了那么多工具和交互界面,因此实际上这些繁杂的工具和界面都是 “反人类” 的——当我们真正使用一个聊天输入框来使用纯自然语言进行交互的时候,这些工具似乎都显得没那么必要了……顺带提一句,这就像手机上无数的 app 一样,我想未来的手机应该是一套统一的交互界面搞定一切的,app 就算有,也应该是工程师考虑的东西,不应是用户考虑的东西,用户不应该花费时间精力在 app 的安装和切换上面。

我的想法是,这个方向兴许是没错的,但是这需要时间一点一点地来证明。我想起了 2000 年的互联网泡沫,市场也许想的方向都是对的,但是它太心急了一些,仿佛一夜之间所有坐电脑前的白领都可以下岗一样。从目前而言,我认为你不能指望做出分析决策的大多数人都具备软件工程师的背景,事实上,从目前的情况来看,AI 在这方面被显著地高估了,并且我认为 Jira 和 Confluence 这样的工具其实并不会受到显著的影响。我自己也用 Windsurf 等等工具协助写代码,但是短期内 AI 的代码能力和如此大程度地替代软件工程师,还差得很远,这一点,我相信很多非专业的人是很难理解的。

另一方面,在相当长的时间内,系统出现的问题,还是会通过 Jira 的 ticket 来跟踪,而无论这是人还是 AI 造成的问题;而数据,无论是人来使用还是 AI 来使用,作用依然是举足轻重的。逐渐地,Jira 和 Confluence 这样的系统也会逐渐革新,以将 AI 的能力逐渐集成进来(比如 Rovo,它尝试提供一层代理,正如前面提到的统一了的输入框一样,封装底下复杂的工具和功能,让交互变得简单)。同时,前面说到的护城河,依然会让向替代品的迁移变得困难。总之,就像早在十九世纪初 George Carley 就提出了现代飞行的原理,但是直到一百年后的 1903 年,莱特兄弟才让飞机上天,工程的问题的难度往往被人低估——我认为这个过程可能确实会发生,但它需要花费大量的时间和投入。

Atlassian 这几年做了不少收购,大致路线我还是能够大概看懂的,主要是围绕他们要解决的问题,收购一些相关的公司,他们的产品可以作为整个解决方案工具集的一部分。比如,Loom 则是一个很好用的屏幕录制和视频分享工具,可以用来帮助会议纪要和内容管理,视频可以和现有的 Jira 等等工具集成。Atlassian 的最终目标,可能是想跳出这个作为单一 “工具” 提供商的圈子,变成一个提供统一开发工作平台的厂商。

但也有一些很难看懂,比如去年收购了 The Browser Company(Arc 和 Dia 浏览器的开发商),因为这个浏览器是 AI 原生浏览器,可以直接理解屏幕上渲染的内容。我想可能他们是要抢占用户使用的入口,这很像互联网公司抢流量入口一样,但是最后的用户体验会是怎样的,让用户抛弃掉现有的浏览器来使用这个新的入口吗?这很难让人信服。

谈过 AI 之后,再来看看 Atlassian 同一领域的竞争对手。整体来看,主要就是 GitHub 和 GitLab。虽说还有一些轻量级和更现代的解决方案,但是从竞争对手来说,我觉得最大的威胁还是来自于 GitHub,因为GitHub 的最大优势就是深度整合的全家桶(一体化),GitHub 可以带来项目管理和代码管理的流量。从我的角度看,对于开发者来说,GitHub 有天然的优势,但是对于非技术人员来说,Jira 和 Confluence 反而占有一个更好的位置;另外一个方面,是 GitHub 在 DevOps 这个圈里面负责的范围还是太小,而 Atlassian 的解决方案可以覆盖更大的部分,包括代码之后的运维等等。当然,这是一个价值千金的问题,我其实很想知道 Atlassian 的管理层有怎样的想法,从长远看打算做什么来应对。

文章未经特殊标明皆为本人原创,未经许可不得用于任何商业用途,转载请保持完整性并注明来源链接 《四火的唠叨》

2026-01-06 12:20:44

自我上次 2018 年回国已经过去超过 7 年了,这次回国呆了超过两周,感触还是很丰富的,整理得不够系统,简单把它们罗列下来。我虽然长期不生活在国内,但是我始终是中国人,也始终用简单的 “国内” 两字替代 “中国国内”,我非常热切地想了解中国国内的变化。当然,时间关系,我的观察不会很深刻,因此我的观点未必都是正确的。

自我上次 2018 年回国已经过去超过 7 年了,这次回国呆了超过两周,感触还是很丰富的,整理得不够系统,简单把它们罗列下来。我虽然长期不生活在国内,但是我始终是中国人,也始终用简单的 “国内” 两字替代 “中国国内”,我非常热切地想了解中国国内的变化。当然,时间关系,我的观察不会很深刻,因此我的观点未必都是正确的。

中国的基建搞得真的很棒,要说出行恐怕中国是最便捷的国家了。期间坐了公交、高铁、卧铺、游轮、出租、网约车,或者是干脆步行……都很方便。我想,这应该是得益于中国超强的基建能力。这是让我无比自豪的一点,虽说以前在国内待着的时候并没有深刻体会。

关于网约车,我的记忆还停留在那个滴滴和快滴烧钱拉客的年代。后来我知道的是,滴滴独打天下了。如今我看到的是,滴滴也似乎未必能玩得过竞争对手了。因为它的竞争对手早就变了,已经是高德地图这样的流量入口。当年阿里下错了很多步棋,但是阿里没有下错高德地图这步棋,这是少有的流量入口应用。我拿高德地图搜网约车,就会显示一堆可选项,来自不同的网约车公司,接着直接对接支付宝,这个平台把端到端做得真是不错。说起高德地图,想起那时候百度地图是通配,再想想百度的其它业务,顺便叹息一下它的没落——真是拿了一手好牌,打得稀烂(比如搜索和地图);好容易盼走了对手(Google),却输给了时代(比如移动互联网);起了个大早,赶了个晚集(比如 AI)。

关于中国的铁路客运,效率依旧是没得说。从浙江的一个小城到广西桂林旅游,去程高铁,回城动车软卧,前者要快四成。两种不同的体验,但是共同点一句话说就是很快速、舒适。小时候绿皮火车的记忆慢慢淡忘,那时候车厢里挤满的人群,无比酸爽的味道,还有在铁路上行驶咯噔咯噔的响声,以及卫生间不可描述的卫生状况……而现在,整个过程都很舒适。

中国经济的三驾马车投资、消费和出口里面,回国后我最先感觉到的是,消费力普遍不足。不只是大宗商品,比如我家乡海边大量的空置房屋,甚至烂尾楼,就说一些普通的步行街,没有什么人气,当然,大城市的情况会好一些。消费这个东西是和经济密切相关的,而经济又是和信心密切相关的。

我问了问家人都使用什么电商平台,得到的答案各异。我是使用京东的,主要还是因为货品普遍靠得住,并且配送比较迅速,大部分两三天内就能收到,还有不少当日达,这在美国还是比较难做到的。现在成本的因素还是占据大头,但我相信如果中国的经济能慢慢地稳住回升,老百姓手里有钱的话,京东的配送优势就能更好地发挥出来了。

这个时代已经变成了一个普遍忧虑的时代,但是忧虑的主线还是老的三座大山:住房、教育和医疗。住房是如今这其中最大的问题,我想上一辈人借着改革开放、人口爆炸以及居民加杠杆的多重优势,获得了相当大的收益,但是这种收益我认为有很大一部分是时代的红利,而非个人能力。如今这个接力棒传不下去了,八零九零后就被迫成为了最后一棒的接盘侠。住房的问题每个人都在说,而教育方面,除去反内卷,我能看到的是一些幼儿园也开始公费化,这是整个社会的进步;医疗方面,我留意到药品价格被打下来了,但是没有医疗保险足够的覆盖,很多人还是因为一病返贫的忧虑而不敢花钱。一些思维开化一些的年轻人,在挣扎无效之后选择躺平,这些都是时代特有的烙印,我觉得舆论媒体需要包容,而非打压这样想法的人,毕竟从长远看,都是社会的进步。

我一直看好中国的发展,趁这次回来,想用人民币买一点基金。但是这个过程挺坎坷,折腾了我不少时间。这个恰好是和前面说的出行和基建完全相反。

银行就像一头大象,似乎笨重得难以跟上这个时代。举个例子,我想在国内买一点基金,通过工商银行的渠道,有无数的限制和烦人的手续。我连着跑了两趟银行也没有彻底搞定。这期间我的感觉就是,我的钱根本就不是我的钱——我取不出来,转不出去,买不了东西,做不了投资,全都有很烦人的上限,而且这个上限还很不容易改,做什么改动还要看流水,还要解释原因……

投资经理笑呵呵地服务,但是申购费居然要 1.2%,而互联网平台(我用的财付通)只有它的 1/10,一开始我得知这个还觉得是不是搞错了,差那么多钱,那银行还搞个屁?果断选择后者,果然整个流程非常顺利。当然,我因为不想开股票账户,就直接买基金,这个申购基金的流程要麻烦得多,连购入价都要等两天才能看到。

从长期投资的角度看,国内我置信程度最高的互联网公司就是腾讯,这次更坚定了我的想法。我经常说的一句话是,在港股市场如果有一笔闲置的钱,而且不知道买哪家公司,那就买腾讯。腾讯已经深入人们的生活,它的护城河可以说看不到边。阿里作为第二梯队,要差一些,尤其是在流量入口方面;当然,电商业务我觉得它是很难打赢拼多多的。除去它们,作为第三梯队,我觉得我能看得懂一些的还有携程。

我本身有克罗恩病,这次因为肠梗阻被迫住了几天医院,有这么几个感受:一个是整体费用比较低,特别是药价,前面已经谈到了;第二个是医生上来就给用了大杀器的药物,比如针对中到重度感染的联合抗生素等等,对于我的轻度感染有杀鸡用牛刀的感觉。当然,我毕竟不是医生,但是我了解到大家都是谨慎为上,目标就是最快速度缓解症状、治疗疾病,这和我过往所理解的在医疗上权衡利弊的理念有所区别。

再有一些病房里的规定,让我觉得不太舒服。比如对于我这样一个血糖正常的年轻人,一天查六次血糖,每四小时一次,结果就是我睡觉也睡不好,我觉得也是似乎有点过度医疗了。

可能很多人已经忘记了当年雾霾的天空,PM2.5 仿佛已经是一个遥远的回忆。这次回国,从下飞机开始空气质量就让人惊艳。能源结构的大换血和产业升级的效果有目共睹。除此以外,马路上的垃圾和随地吐痰等等情况也少了很多。不过来到郊区野外,还是能见到不少垃圾。

我是在小红书上面找的桂林本地旅行中介,没有任何购物环节,纯是跟车景点一个一个地玩,我们包车游览了完整的五个白天。桂林山水甲天下,我的桂林之行的过程也很顺利,感受非常好。和导游聊了聊,这两年内地和香港游客增加,但外国游客减少。希望国家之间的关系能够更健康和平稳,这样中国的旅游资源能够在世界范围内受到更多的欢迎。

中国文化的一个根基就是美食,我相信无论出国多少年,无论接受多少各个国家的食物,我始终是那个要归家的少年,而我的胃始终是中国胃。踏上中国的土地,敞开吃的第一顿不是大鱼大肉、山珍海味,而是油条、小笼包、稀饭和茶叶蛋。在美国也能吃到口味各异的中餐,但时隔七年能够吃到家乡的味道,仿佛旅程的仆仆风尘和满身疲惫都被瞬间治愈了。

文章未经特殊标明皆为本人原创,未经许可不得用于任何商业用途,转载请保持完整性并注明来源链接 《四火的唠叨》

2025-11-24 11:30:38

作为业余爱好,一直很喜欢研究企业的商业模式。我以往觉得电子商务这个赛道竞争很激烈,生意很难做,尤其是中国当前的环境下,近些年在商业模式上也没有太多有意思的创新。快两年前,写过一点关于拼多多的,但主要是批评,我不喜欢它的生意模式,我觉得它的壮大会打压中国的品牌成长。这个观点至今依然成立,不过,除此以外,那个时候我对于拼多多的理解还是比较浅薄的。随着这两年拼多多的成功,我觉得我看到了它越来越多以前没有看到的东西。这些东西让我越来越觉得,黄峥,真的是个眼光很长远,执行上也很厉害的人。

作为业余爱好,一直很喜欢研究企业的商业模式。我以往觉得电子商务这个赛道竞争很激烈,生意很难做,尤其是中国当前的环境下,近些年在商业模式上也没有太多有意思的创新。快两年前,写过一点关于拼多多的,但主要是批评,我不喜欢它的生意模式,我觉得它的壮大会打压中国的品牌成长。这个观点至今依然成立,不过,除此以外,那个时候我对于拼多多的理解还是比较浅薄的。随着这两年拼多多的成功,我觉得我看到了它越来越多以前没有看到的东西。这些东西让我越来越觉得,黄峥,真的是个眼光很长远,执行上也很厉害的人。

最早的时候,我以为拼多多的核心就是低质量、低价的策略。后来我渐渐明白,所谓的低价策略,只是最肤浅的一个表象。

如果退到十年以前,应该很少有人能同意,在如此激烈的电子商务赛道上,已经有了老牌的阿里巴巴,还有重供应链的京东,拼多多能够挤进来,分到一杯羹。而如今,不仅如此,它的增长居然已经让这两家都难以望其项背。

说到阿里巴巴,如今看,它还是犯了一个企业扩张以后变得局限、傲慢的通病。早些时候马云就评论京东说这种重资产玩不转,到后来张勇则认为拼多多只会帮助阿里巴巴教育用户和开拓市场,阿里巴巴错过了太多的机会。

拼多多的核心商业模式是什么,招股书中讲是中国的 Costco+Disney,零售+娱乐。但是它没有对比阿里巴巴和京东,来进一步细致地说明它是打算怎么赚钱的。看起来这些零售电商很接近,其实很不一样。阿里最值钱的是什么,是商家;但是拼多多呢,是消费者。就连对于 “砍一刀” 这样的基于社交的病毒式营销,也是基于消费者这个核心。拼多多教育用户,你要关心你买的产品和价格,但不要关心是什么品牌、是谁生产的。拼多多不在乎丢失商家,而是推行白牌商品,达到极致的性价比,以最简单的低价方式来留住用户。所以说,传统电商那套基于流量变现的策略在拼多多这里行不通了,拼多多更关心的是单一性价比高的商品,谁来拿订单?很简单,价低者得。

Costco 玩法的其中一个核心就是由它来代替用户选择性价比高的品牌,利用巨大的订单量,来和生产的商家谈价格。在同样具备规模效应的情况下,这是它和沃尔玛这种靠商品品类之全而获得用户的商业模式来说,最大的优势之一。比方说,在 Costco 买衣服,你不会找到很多的品类,每种衣服的类型可能就那么一两种衣服,但是衣服的质量可以,而且性价比没的说。一句话概括,单一的种类,巨大的订单量。

阿里也好,京东也好,它们都可以把消费者直接对接到商家,砍掉中间环节,但是这样的消费者依然是没有议价能力的,因为消费多少不能提前确定,每一单的规模又小得可怜。但是类似于 Costco,拼多多的做法是什么?把大量消费者的需求捆绑起来,它们出动去和生产产品的商家谈,这就让商家愿意去用一个更低价格来换取很早就可以确定的大订单。商家被迫报低价来抢单,商家和商家之间抢拼多多这个大客户,这种模式和白牌商品有着最天然的契合。可以认为,这是团购的升级版,我觉得这才是拼多多最核心的玩法。

提到了 Costco,再来说 Disney,这主要说的是娱乐和社交。和传统电商个人选择和购买的模式不同,拼多多可以利用团购的本质来强化社交这个行为。因为团购需要多人参与,拼多多就可以提供一个可以游戏的平台,这也是其它传统电商很难和它竞争的一个方面。无论是养成类的多多果园(这个真是一个提高日活的绝招)还是社交裂变类的砍一刀,还有那些对于很多人来说看起来并不高级的幸运转盘……购物变成了只是游戏过程中的一个环节。

再来看看拼多多扩张的过程当中,那些成功而重要的决策。

首先是 “砍一刀” 这样的病毒式营销,这可能是像我这样的人最早听说拼多多的时间。那段时间,恰好是微信摇一摇春晚大肆撒钱的事情发生之后。众所周知,腾讯的这一方面的眼光总是很独到,藉由微信等等流量平台,他们也有非常大的用户数据和这方面的经验。腾讯投资了拼多多,或许这盘大棋中,也告知了拼多多这样一个事实——大量的网民们,他们的微信账户有着红包摇来的钱,这是最好的建立拼多多性价比消费心智的时间。配合 “砍一刀”,拼多多的初始的大规模获客就这样做到了。

第二件火爆的事情可以说是拼多多玩的 “仅退款”,阿里和京东根本当时根本就没法快速跟进。因为他们需要考虑这些极度便利消费者的措施,对于品牌相当负面的摧残和打压。品牌就意味着溢价,有了溢价就没法极度地考虑性价比。从这个角度来说,长期看,拼多多的市场很大,并且阿里和京东根本没有办法去抢,无论是国内还是海外。阿里也许能把很多第二产业、第三产业做成,能把阿里云做成,甚至能把芯片也搞起来,但是传统电商,对于大多数人来说,考虑到目前大多数人的消费习惯和能力,我觉得它长期下来是不可能搞得过拼多多的。

再有,拼多多对于资金的分配,也是极致的典范。想想阿里什么都要投钱,铺开来如此之大的摊子,什么都搞,拼多多非常本分,就做自己风格的电子商务,就是扎根于农村下沉市场,和阿里、京东比起来极少的员工数,尽可能地避免重资产,连办公楼都是租的。每次财报,都是不分红,并且低调地强调未来的风险,最近火爆的 AI,拼多多也似乎尽量去避免接触,这样的管理层,在如今这个习惯于画大饼的世界似乎真是独一无二。

接着,我想到了微博和小红书。微博是大 V、名流为核心的玩法,无名人士的发声微不足道;小红书呢,则是基于草根的玩法,它的推荐系统是最核心的资产,它可以让一个无名之辈的帖子出现在感兴趣的用户的眼前。我觉得这是小红书和微博最大的区别,这也是微博已经是上一代互联网产品,逐渐衰落的原因之一。以此类比,阿里巴巴上的品牌企业,就是大 V 和名流;拼多多上的无数白牌商家,就像是不知名的草根。单一草根势单力薄,但是拼多多这样的平台把他们的力量汇聚起来,消费者买到东西的时候兴许不知道是哪家草根商家生产了他的货品,但是千千万万的草根商家就能够借助这个平台,靠着生产白牌产品,把自己的小小生意做下去。这样看,其中的历史意义显而易见。

最后,事物还是要从两面看。拼多多的商业模式风险也非常显著,我觉得这可能也是市场不愿意给它一个足够溢价的原因之一。最大的风险还是在监管和地缘政治方面的,比如美国 “小额豁免” 漏洞的利用,最近已经补上了,且看它在美国市场上之后的表现。还有就是一些合规调查,包括仿冒商品等等方面,其实有很大程度上也是要限制中国商品在其它市场上低价的倾销。

总之,这林林总总的事情,无论是战略还是实施,都让我觉得拼多多真是一家非常厉害的企业,黄峥真的是一个很厉害的人。黄峥受到段永平影响很大,他要 “做对的事情,并把事情做对”,但我不知道对于他来说,什么样的事情是对的事情。当然,我觉得我还是没有很深刻地读懂拼多多,以上只是我现在的思考,这真是一家太有意思的企业。

文章未经特殊标明皆为本人原创,未经许可不得用于任何商业用途,转载请保持完整性并注明来源链接 《四火的唠叨》

2025-07-27 10:55:18

首先,从高维度看,OAuth 是要解决什么问题?

首先,从高维度看,OAuth 是要解决什么问题?

OAuth 要解决的是客户端在不知道和不使用用户密码的情况下,怎么样安全访问并获取用户所拥有的资源的问题。

顺带说一句,经常和 OAuth 一起谈到的 OIDC 则是解决了用户信息(profile)获取的问题。简单说,OAuth 解决了 Authorization 的问题,OIDC 解决了 Authentication 的问题。

OAuth 有几种角色:

所以 OAuth 就是用户想通过某种机制,通过 Client 和 Authorization Server 交互来获得能够访问资源的 token。

对于 OAuth2.0 的授权流程,可以根据 grant type 来做个归类。下面的图示全部都来自 Auth0 的官方文档。

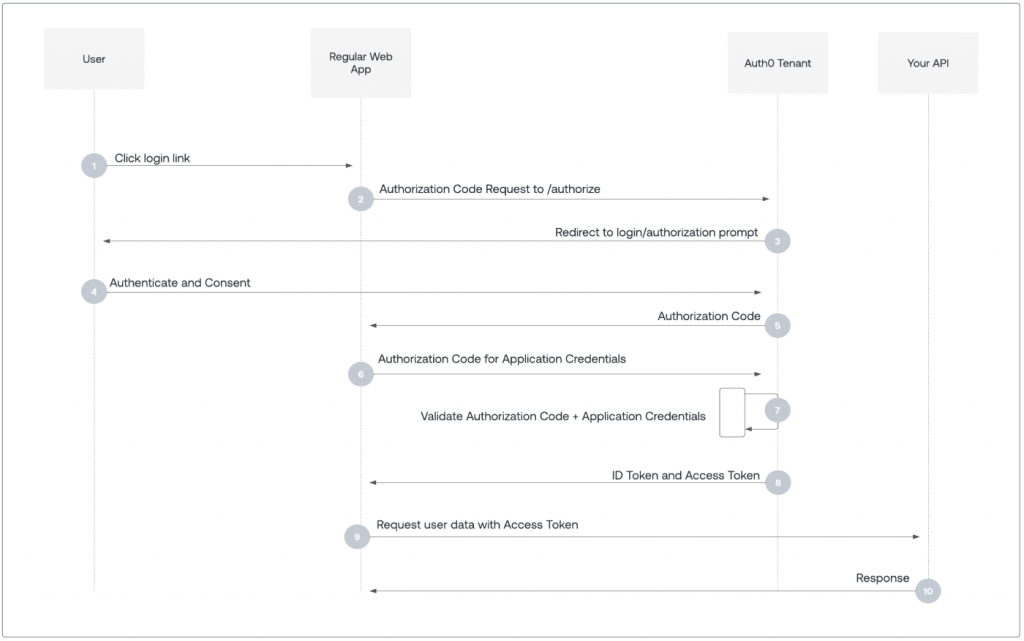

1. Authorization Code:用户访问 web app,web app 的后端请求 auth server,于是重定向到登录页面,用户输入登录信息,auth server 就给 web app 一个授权码,这个授权码通过 callback URL 返回,而这个参数一般放在这个 url 的参数中,比如:http://…/callback?token=TOKEN。之后 web app 就可以拿着授权码去取 token 了。这种方式不需要用户这边存放任何 secret,但是需要用户参与 consent,并且具备 web app 的后端,因为和 auth server 的交互主要都是 web app 后端完成的。

但是这种方法存在一些 concern,比如说,这个 code 如果在返回途中被截获怎么办,截获者就可以使用这个 code 来获取 token 了。

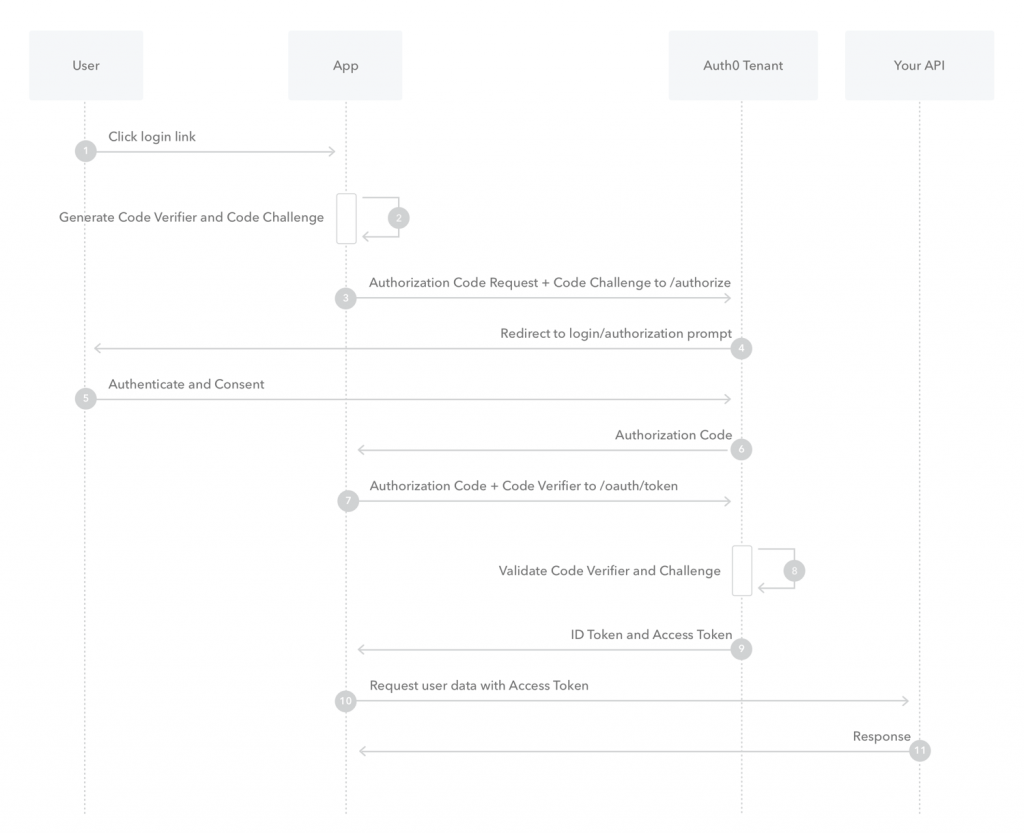

2. PKCE:对于上述问题,有一个改进的办法,就是使用 PKCE(Proof Key for Code Exchange)来给它增强。基本原理是,客户端生成一个随机字符串 code verifier,根据一个算法 code challenge method 来生成它的 hash(challenge),获取授权码 code 的时候需要把这个 method 和 challenge 带过去;接着,code 正常返回,但之后客户端拿着 code 去获取 token 的时候,需要带上这个 code verifier,这样 auth server 就可以根据之前拿到的 method 和 challenge,以及刚得到的 code 和 code verifier,来校验用户是不是可以得到这个 token。

在这种情况下,如果 code 被劫持,那么对方拿到了 code,却没有 code verifier,也就没什么用。

这种方法是比较推荐的,对于一些 CLI 登录使用这种方法的时候,重定向 URL 可以是一个带有 code 的指向 localhost 的地址以被 CLI 捕获。

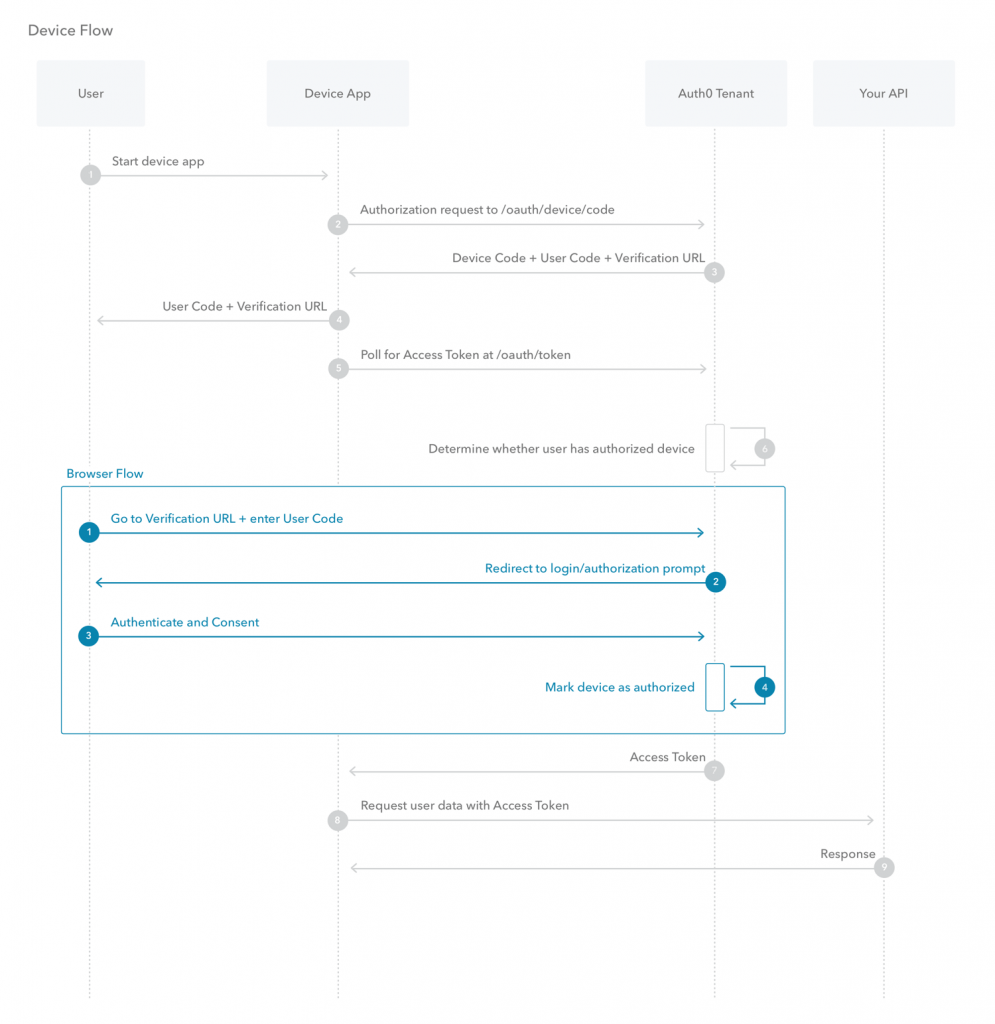

3. Device Code:前面说到的 Authorization Code 这种方法还有一个变体,就是对于一些需要用户参与,但是又没有浏览器(或者自动打开浏览器)的场景下,这个重定向到浏览器来获取用户 consent 的过程,被其它方式来取代,这种变体可看做名为 Device Authorization 的流程:

可以看到,上面的浏览器重定向的过程被替换成了返回 code 和 verification url,然后用户使用 verification URL 加上这个 user code 来完成 consent 的过程,在这个过程完成之后,这个 device 才被授权。在这个过程完成之前,需要 app 不断去 poll 检查是不是 device 已经被授权了。

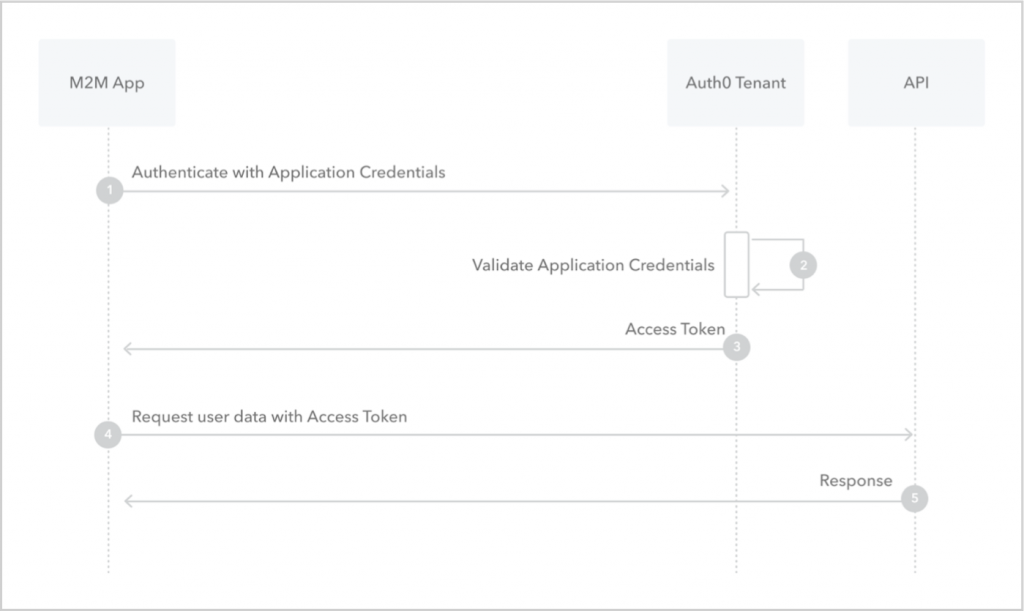

4. Client Credential:前面说到的 Authorization Code 虽然好用,但是需要用户手动登录确认的过程,对于一些没有人参与的 M2M(machine-to-machine)系统而言,这是不现实的。因此在 client id 的基础上,再加上一个 client secret,一样可以完成 auth 的流程。这种场景其实就相当于是 client 和 resource owner 是同一个了:

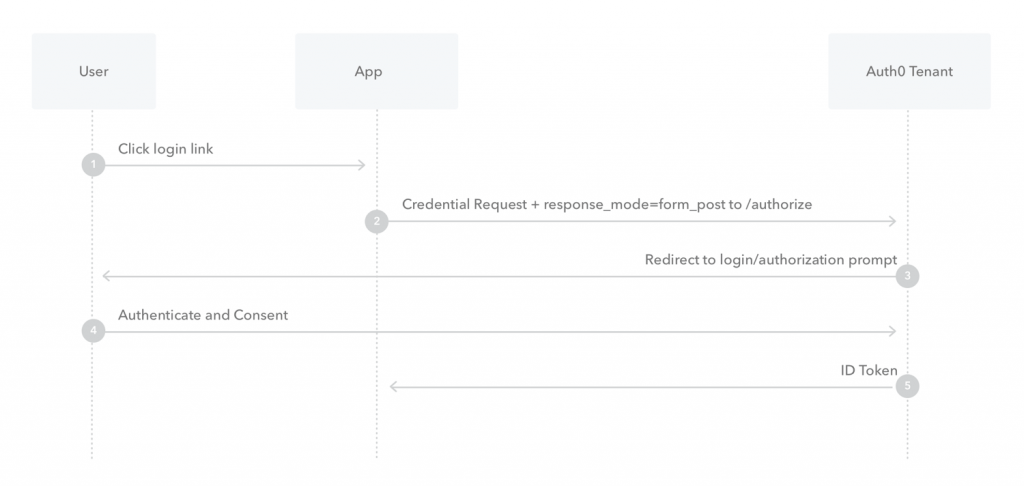

5. Implicit:这种其实就是上面 Authorization Code 的简化版,去掉了 code 的环节,直接发 code。这种方式在 app 只有前端的场景下(比如 SPA)使用,因为它没法进行后端和 Auth Server 的通信。但是这种方式因为安全性低,因而不推荐,因为即便是 SPA,还是可以用前面说的那种 PKCE 增强的 Authorization Code 方式来实现。

再来看这个 callback 的 URL,和前面提到的 Authorization Code 流程不一样的是,它返回的 token 放在 URL 的 fragment 里面,而不是 query 里面,比如:http://…/callback#token=TOKEN,这样做的好处是这个 TOKEN 不会在浏览器跳转的时候送到服务器,就不容易泄露。

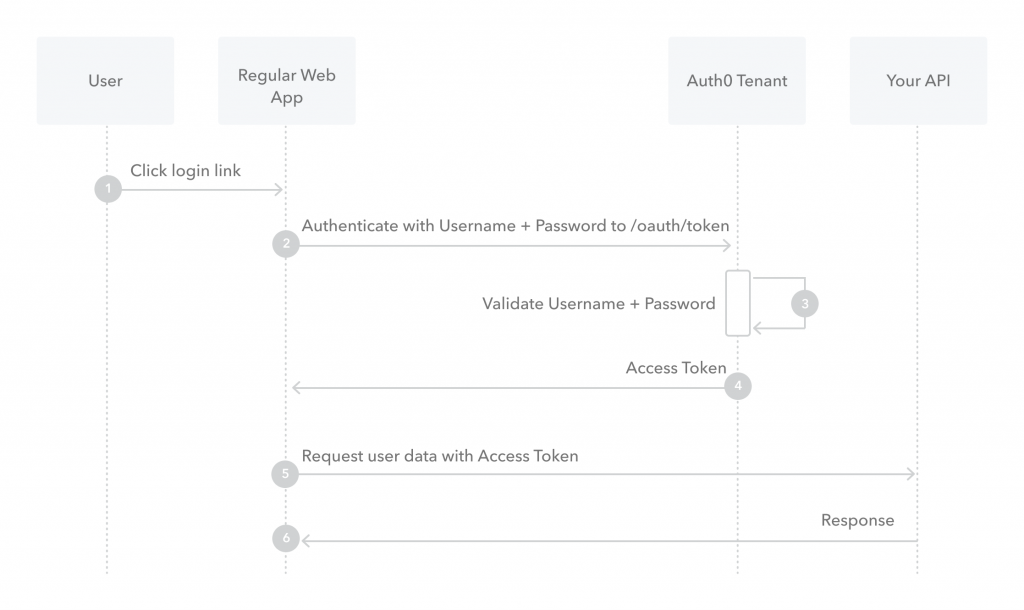

6. Password:这种方式其实就是让 client 获知用户的用户名和密码,属于风险比较大的做法,要求这个 app 是用户百分百信任的——这也就是说,它没有解决 OAuth 本身应该解决的问题,因此很少使用。

文章未经特殊标明皆为本人原创,未经许可不得用于任何商业用途,转载请保持完整性并注明来源链接 《四火的唠叨》